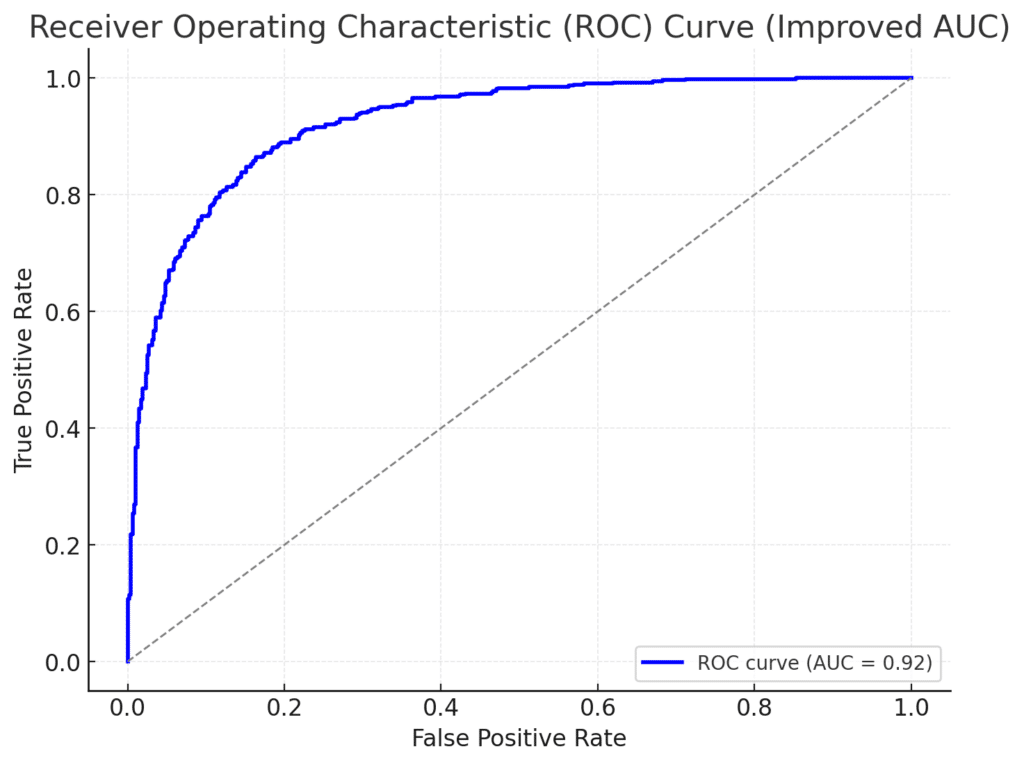

La plupart des projets de data science s’appuient sur des métriques techniques comme l’AUC, la précision ou le RMSE pour évaluer la qualité d’un modèle. Ces indicateurs sont certes indispensables pour comparer des algorithmes ou mesurer leur performance statistique. Mais ils ne disent rien de leur impact économique ou opérationnel.

Dans cet article, nous allons :

- Passer en revue les principales métriques techniques et leurs limites,

- Voir pourquoi il est essentiel de les compléter par des indicateurs métier,

- Illustrer cette approche avec deux cas concrets :

- La détection de fraude

- La prévision de la demande

L’objectif : vous donner les clés pour aller au-delà des scores et mesurer la valeur réelle de vos modèles.

1. Les métriques techniques : tour d’horizon et limites

1.1 Les fondamentaux pour la classification binaire

Lorsque vous cherchez à détecter une classe particulière (fraude, churn, litige, spam, etc.), le modèle renvoie souvent une probabilité ou un label (oui/non). Pour l’évaluer, vous utilisez :

| Métrique | Définition | Quand l’utiliser | Limites |

|---|---|---|---|

| Accuracy (exactitude) | Proportion de bonnes prédictions | Données équilibrées (quand la classe positive n’est pas trop rare) | Trompeuse si la classe positive est rare (< 5 %) |

| Recall (rappel) | Proportion de positifs correctement détectés sur l’ensemble des positifs réels | Quand les faux négatifs sont coûteux (ex : fraude non détectée) | Ne pénalise pas les faux positifs (risque de « sur-alerte ») |

| Precision (précision) | Proportion de vrais positifs parmi les prédictions positives | Quand les faux positifs sont coûteux (ex : enquêtes inutiles, perte de temps) | Ne prend pas en compte les faux négatifs (risque d’en louper) |

| F1 Score | Moyenne harmonique de précision et rappel | Pour un compromis entre rappel et précision | N’intègre pas d’aspect métier (pas de notion de coût ou de gain) |

| AUC / ROC | Sur un échantillon de paires (positif/négatif), probabilité que le modèle classe la paire dans le bon ordre | Comparer différents modèles de manière globale, sans se fixer de seuil | Ne donne pas d’information absolue (une AUC de 0,8 peut être insuffisante ou suffisante selon le business) |

| Lift | Gain relatif vs une sélection aléatoire, pour un certain décile de population | Ciblage marketing, priorisation de dossiers | Parfois difficile à interpréter pour les non-spécialistes |

Exemple : si vous avez 1 % de fraude, un « modèle » qui prédit “aucune fraude” aura déjà 99 % d’accuracy ! Inutile de dire qu’il est inacceptable en pratique.

… et pour les cas multiclasse ?

Lorsque votre problème dépasse la simple opposition « positif/négatif » (ex. classer un document en 3 catégories, prédire le segment d’un client parmi 5 segments, etc.), vous entrez dans le multiclasse. Les métriques les plus courantes (précision, rappel, F1) existent alors en plusieurs variantes :

- Macro-average : on calcule la métrique par classe, puis on moyenne (chaque classe compte autant, même si elle est minoritaire).

- Micro-average : on additionne tous les vrais positifs, faux positifs et faux négatifs sur l’ensemble des classes, puis on calcule la métrique (plus pertinent si les classes sont de taille très variable).

- Weighted-average : on pondère la métrique de chaque classe selon sa proportion dans les données (un compromis entre macro et micro).

Exemple : pour un modèle qui classe automatiquement des tickets SAV en 3 urgences (faible, moyenne, haute), le macro-F1 va donner la même importance à la classe « faible » et à la classe « haute », même si la seconde est beaucoup plus critique.

Inversement, un micro-F1 va davantage refléter la performance globale, mais il peut masquer un faible rappel sur une classe cruciale.

1.2 Les fondamentaux pour la régression (prédiction de quantités)

Lorsque vous prédisez une valeur continue (montant, durée, volume de ventes, etc.), on utilise souvent :

| Métrique | Définition | Quand l’utiliser | Limites |

|---|---|---|---|

| MAE (Mean Absolute Error) | Erreur absolue moyenne (en unité de la variable : €, pièces, etc.) | Quand toutes les erreurs ont le même poids | Ne pénalise pas fortement les erreurs extrêmes |

| RMSE (Root Mean Squared Error) | Racine carrée de la moyenne des carrés des écarts entre prédiction et vrai | Quand on veut mettre l’accent sur les grosses erreurs | Plus compliqué à interpréter pour les non-experts |

| MAPE (Mean Absolute Percentage Error) | Erreur moyenne en pourcentage | Données hétérogènes en volume (produits très différents en quantité) | Instable si certains volumes sont proches de 0 |

| R² (coefficient de détermination) | Proportion de la variance expliquée par le modèle | Vision globale de la « qualité » du modèle | Peu exploitable en pratique pour évaluer les coûts ou gains liés à l’erreur |

Exemple : un RMSE élevé signifie que le modèle fait des erreurs parfois massives. Mais un RMSE un peu plus bas n’est pas forcément “rentable” si le coût de l’erreur varie fortement selon la catégorie de produit (ex. casse d’invendus vs. manque à gagner).

Pour une liste plus complète, c’est ici (en anglais).

1.3 Les deux grands pièges à éviter

- Optimiser une métrique sans tenir compte de la réalité terrain

- Exemple : viser un rappel maximal en détection de fraude peut générer des taux de faux positifs énormes, saturant les équipes de contrôle.

- Ne communiquer que ces scores techniques aux métiers

- Les décideurs ne comprennent pas forcément la différence entre “F1 = 0.85” et “F1 = 0.90” ; ce qu’ils veulent savoir, c’est “Combien ça me coûte ? Quel gain pour mon activité ?”

2. Du score aux indicateurs métier

Pour convaincre les décideurs et valoriser votre travail, vous devez quantifier l’impact concret de vos prédictions. Quelques exemples d’indicateurs métier :

- Coût total des enquêtes (détection de fraude)

- Montant de fraude évitée

- Coût du surstock vs coût de la rupture (prévision de la demande)

- ROI (Return on Investment) : bénéfice supplémentaire lié à l’usage du modèle, comparé à la situation antérieure

- Temps gagné par les équipes (réduction de la charge manuelle)

L’idée est de relier les scores du modèle à des éléments financiers ou opérationnels.

Règle d’or : toujours discuter avec les métiers pour définir la “charte de scoring” ou la fonction de coût / gain la plus pertinente.

Voici quelques approches pour affiner cette réflexion :

2.1. Coûts et bénéfices directs

- Coût de traitement ou d’action :

- Temps et ressources alloués (heures de travail, coût d’un contrôle manuel, d’une enquête, etc.).

- Frais d’opération (ex. coût d’acquisition d’un client qu’on cible par erreur).

- Bénéfice unitaire :

- Valeur moyenne d’une transaction interceptée (fraude) ou d’un client retenu (churn).

- Marge moyenne par produit pour la prévision de la demande (ex. 15 € par unité vendue).

- Calcul du profit ou de la perte :

- S’il s’agit de classification (fraude, litige, spam), formaliser un tableau de gains/pertes pour chaque combinaison (vrai positif, faux positif, etc.).

- S’il s’agit de prévision, construire une fonction de coût intégrant l’impact d’une surestimation ou sous-estimation (stock, ventes manquées, etc.).

Exemple : dans un call center, chaque faux positif (appel inutile) coûte 5 € de ressources temps, tandis que chaque vrai positif (prospect vraiment intéressé) rapporte 30 €. Un faux négatif (prospect potentiellement rentable qu’on ne rappelle pas) est un manque à gagner d’environ 30 €.

2.2. Outils de projection et scénarios

- Analyse de sensibilité :

- Varier certains paramètres (coût moyen d’une fraude, marge par produit, etc.) pour comprendre à quel point les hypothèses influencent l’évaluation.

- Simulation Monte Carlo :

- Générer des scénarios probables pour modéliser l’incertitude.

- Permettre aux parties prenantes de voir, par exemple, la distribution probable du ROI du modèle.

- Scénarios extrêmes :

- Que se passe-t-il si la conjoncture change ? Si la proportion de fraude double ?

- Évaluer la robustesse du modèle face aux fluctuations métiers.

Exemple : pour un modèle de prévision de la demande, on peut simuler plusieurs « niveaux de demande » (baisse, stable, forte hausse) et regarder comment se comporte le coût total (surstock + rupture) dans chaque cas.

2.3. Indicateurs orientés client et satisfaction

Au-delà du gain financier immédiat, certaines organisations attachent une importance particulière à la satisfaction client, à la fidélisation ou à l’image de marque :

- Customer Satisfaction (CSAT) :

- Par exemple, un modèle de routage des tickets SAV vers le bon service. Un bon modèle peut réduire le temps de résolution, améliorant le CSAT.

- On peut traduire une hausse de satisfaction en rétention client, donc en chiffre d’affaires prévisionnel.

- Net Promoter Score (NPS) :

- Pour un modèle de recommandations produits, évaluer si les clients se disent plus enclins à recommander la marque.

- Taux d’attrition :

- Dans le cas d’un modèle multiclasse segmentant la clientèle en différents niveaux de risque de départ, l’amélioration de la précision sur la classe « high risk » peut se traduire par une baisse du churn, donc un gain en valeur vie client (LTV).

Attention : ces indicateurs « clients » sont plus indirects et nécessitent des enquêtes ou des calculs complémentaires (valeur vie client, propension à recommander, etc.). Mais ils sont souvent plus parlants pour la direction marketing ou commerciale.

2.4. Indicateurs d’efficacité opérationnelle

Un modèle peut avoir un impact interne :

- Temps gagné ou réduction de la charge de travail :

- Ex. : un modèle de tri automatique qui filtre 80 % des cas simples, libérant les équipes pour des tâches à plus forte valeur ajoutée.

- On peut évaluer l’équivalent temps plein (ETP) économisé.

- Taux d’automatisation :

- Combien de dossiers supplémentaires traités à effectif constant ?

- Quelle productivité en plus (dossiers / heure) ?

- Amélioration de la fiabilité :

- Réduction des erreurs humaines, standardisation du processus.

- Peut se traduire en coûts d’erreur évités (dédommagement, retours clients…).

Ces métriques sont cruciales pour justifier un ROI opérationnel, même si le gain financier direct est parfois moins évident à chiffrer.

2.5. Indicateurs de durabilité ou RSE (Responsabilité Sociétale des Entreprises)

De plus en plus, les entreprises prennent en compte des critères extra-financiers :

- Réduction de gaspillage (prévision de la demande alimentaire pour éviter le périmé).

- Empreinte carbone (modèles d’optimisation logistique diminuant les trajets à vide).

- Équité et non-discrimination (modèle de scoring de crédit, d’embauche, etc.).

Exemple : une entreprise agroalimentaire peut chiffrer l’impact de prévisions plus précises en tonnes de nourriture non jetées, ce qui vaut de l’or pour sa politique RSE.

2.6. Combiner métriques techniques et indicateurs métier dans un “scorecard” complet

Pour piloter efficacement et convaincre en interne, construisez un tableau de bord (scorecard) qui :

- Réunit les métriques techniques essentielles (F1, AUC, RMSE, etc.) pour assurer la robustesse statistique.

- Agrège les indicateurs métier : profit, coût, satisfaction, temps gagné, etc.

- Montre l’évolution dans le temps :

- Compare la version actuelle du modèle à la précédente, ou au mode de fonctionnement sans modèle.

- Illustre la tendance (amélioration continue, ou dégradation à cause d’un drift de données).

La clé est de rendre visibles ces indicateurs à toutes les parties prenantes : data scientists, managers, direction générale… pour que chacun y trouve son niveau de lecture.

3. Cas pratique 1 : Détection de fraude

Imaginons un modèle de classification binaire pour détecter les opérations frauduleuses :

- 1 000 transactions à traiter,

- 50 fraudes réelles (5 %),

- Coût d’un contrôle : 10 €,

- Gain moyen quand on détecte et bloque une fraude : 500 €.

3.1 Seuil de décision et profit net

Le modèle renvoie une probabilité de fraude pour chaque transaction (entre 0 et 1). On convertit cette probabilité en décision (« on contrôle ou pas ») via un seuil.

- Seuil élevé (p. ex. 0,9) : on ne contrôlera que les transactions quasi certaines d’être frauduleuses, donc peu d’alarmes, peu de faux positifs, mais aussi des fraudes manquées.

- Seuil bas (p. ex. 0,5) : on déclenche plus de contrôles, on attrape plus de fraudes, mais on paye plus de contrôles inutiles.

Exemple de tableau simplifié

| Seuil | Contrôles déclenchés | Fraudes détectées | Faux positifs | Coût des contrôles | Gain brut | Gain net |

|---|---|---|---|---|---|---|

| 0.9 | 50 | 30 | 20 | 50 × 10 € = 500 € | 30 × 500 € = 15 000 € | 14 500 € |

| 0.7 | 120 | 40 | 80 | 120 × 10 € = 1 200 € | 40 × 500 € = 20 000 € | 18 800 € |

| 0.5 | 250 | 45 | 205 | 250 × 10 € = 2 500 € | 45 × 500 € = 22 500 € | 20 000 € |

Ici, le seuil 0.5 permet de détecter plus de fraudes et apporte 20 000 € de gain net. C’est plus intéressant que 0.7 ou 0.9.

Pourtant, en pur F1 score, il se peut qu’un autre seuil apparaisse optimal. L’évaluation métier vous montre comment choisir le seuil de décision en fonction du profit.

3.2 Courbe de profit cumulée

Une manière efficace de visualiser ce phénomène est de tracer la courbe de profit (ou de “gain net”) en fonction :

- Du nombre de transactions contrôlées (en %)

- Ou de différents seuils (de 0 à 1)

Cela permet de repérer rapidement le plateau optimal et de prendre une décision éclairée.

4. Cas pratique 2 : Prévision de la demande

Supposons un modèle de régression qui prédit combien d’unités d’un produit vont se vendre la semaine prochaine. L’objectif est d’ajuster les stocks pour minimiser :

- Le surstock (coût de stockage, risque d’invendus),

- La rupture (vente perdue, déception client).

4.1 Fonction de coût asymétrique

Toutes les erreurs n’ont pas le même poids :

- Surstocker 1 unité peut coûter 2 € (entreposage, possible rabais).

- Rater 1 unité en cas de demande forte peut coûter 10 € (vente manquée, possible insatisfaction durable).

On peut traduire cela dans une formule de coût :

import numpy as np

# Exemple simplifié

y_true = np.array([100, 120, 80]) # Ventes réelles

y_pred = np.array([110, 100, 90]) # Prédictions du modèle

cost_of_overstock = 2

cost_of_shortage = 10

cost = np.where(

y_pred > y_true,

(y_pred - y_true) * cost_of_overstock,

(y_true - y_pred) * cost_of_shortage

)

print(cost) # Coûts pour chaque prédiction

print(cost.sum()) # Coût total

- Lorsque

y_pred>y_true, on a du surstock → coût de 2 € par unité de surplus. - Lorsque

y_pred<y_true, on a une rupture → coût de 10 € par unité manquante.

Cet indicateur est plus parlant que le simple RMSE, car il reflète l’impact financier.

4.2 Simulation et arbitrages

Le plus souvent, on ne commande pas exactement la valeur prévisionnelle : on ajoute ou on retranche une marge de sécurité (ex. “prévoir +10 %”).

- On peut simuler plusieurs scénarios de commande : “base + 5 %”, “base + 10 %”, etc.

- Calculer le coût total (surstock + ruptures) sur plusieurs semaines ou plusieurs produits.

- Choisir la marge qui minimise le coût attendu ou le rapport avec le stock existant.

Une fois encore, la métrique métier (coût total des erreurs) guide la décision.

5. Construire des dashboards de performance métier

Une fois que vous avez défini des métriques opérationnelles (coût, gain, temps gagné…), vous pouvez :

- Les calculer automatiquement à chaque entraînement ou nouvelle version du modèle,

- Les tracer dans un dashboard accessible aux parties prenantes (Streamlit, Power BI, Dataiku, etc.),

- Les historiser pour monitorer l’évolution de la performance dans le temps (MLOps avec MLflow, Weights & Biases…).

5.1 Visualisations clés

- Profit curve : gain net en fonction du seuil (cas classification).

- Cost curve : coût total selon la marge de sécurité (cas régression).

- Lift chart : pour voir, par décile, l’efficacité du ciblage vs un ciblage aléatoire.

5.2 Adapter la présentation aux métiers

La valeur d’un modèle n’apparaît clairement que lorsqu’on parle le langage des métiers. Les indicateurs de type “F1 = 0,85” sont utiles entre data scientists mais moins pour un responsable financier ou un logisticien.

- « Grâce à ce modèle, on économise 20 000 € par mois »

- « On a réduit de 30 % les enquêtes infructueuses »

- « On a amélioré notre taux de service en magasin de 5 points »

Ces phrases ont plus d’impact qu’un score technique.

6. Conclusion : un modèle utile, pas juste performant

Un bon score (AUC, F1, RMSE…) ne garantit pas un retour sur investissement positif. C’est pourquoi il est essentiel de :

- Travailler avec les métiers pour définir des métriques qui capturent le coût et le bénéfice des décisions,

- Aller au-delà des scores classiques,

- Monitorer les indicateurs métiers au long cours pour ajuster seuils, marges ou stratégies.

C’est seulement quand la performance prédictive se traduit en création de valeur — gains financiers, meilleure satisfaction client, efficacité accrue — qu’on peut parler de succès.

Et pour y arriver, il faut mesurer et communiquer cette valeur de façon claire et adaptée.

En résumé

- Les métriques techniques (AUC, F1, RMSE…) sont indispensables pour la phase d’entraînement et de benchmark.

- Elles ne suffisent pas à appréhender l’impact concret sur le terrain (coût, gains, temps, satisfaction).

- Il est vital de quantifier l’enjeu métier : combien coûte un faux positif, un sous-stock, un faux négatif ?

- Cette évaluation business doit être intégrée dès le début du projet de data science et monitorée régulièrement.

Un modèle est un outil. Il n’a de valeur que s’il vous aide à prendre de meilleures décisions.

Besoin d’accompagnement pour vos projets de data science ?

Chez Stat4decision, nous aidons nos clients à construire et monitorer des solutions analytiques à fort impact métier. Du choix des métriques à la mise en production, nous mettons la technique au service de votre performance.

Envie d’en discuter ? N’hésitez pas à nous contacter.

Partager cet article