Cette première moitié de l’année a été extrêmement riche en nouveautés et nous a permis de confirmer la force d’un certain nombre d’outils dans le domaine de la data science et du développement. J’en ai sélectionné 4 qui me paraissent spécialement intéressants. Ce choix d’outils data science est totalement subjectif et relèvent de mon utilisation personnelle.

1. L’exploration des données avec Jupyter Lab

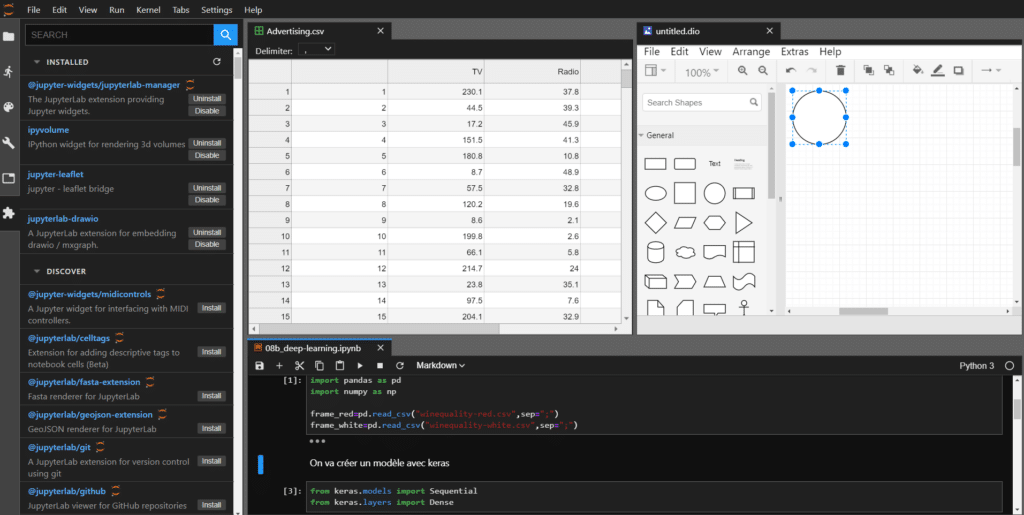

Je vous avais déjà parlé de Jupyter Lab l’évolution des Jupyter Notebook ici. Cet écosystème s’est étoffé avec la présence de nombreux widgets qui permettent de le rendre encore plus interactif. Par ailleurs, le nombre de nouveaux outils disponibles pour Jupyter Lab a augmenté très rapidement avec un éditeur de texte, de nombreux noyaux améliorés, un terminal, un éditeur du type VIM, de quoi construire des schémas, vous trouverez de nombreuses infos ici.

De plus, un débogueur pour Jupyter Lab est en cours de développement ce qui permettra à cet écosystème d’être encore plus complet tout en étant multi-langages grâce aux noyaux (il y en a de plus en plus et ils s’améliorent).

2. Le développement avec VS Code

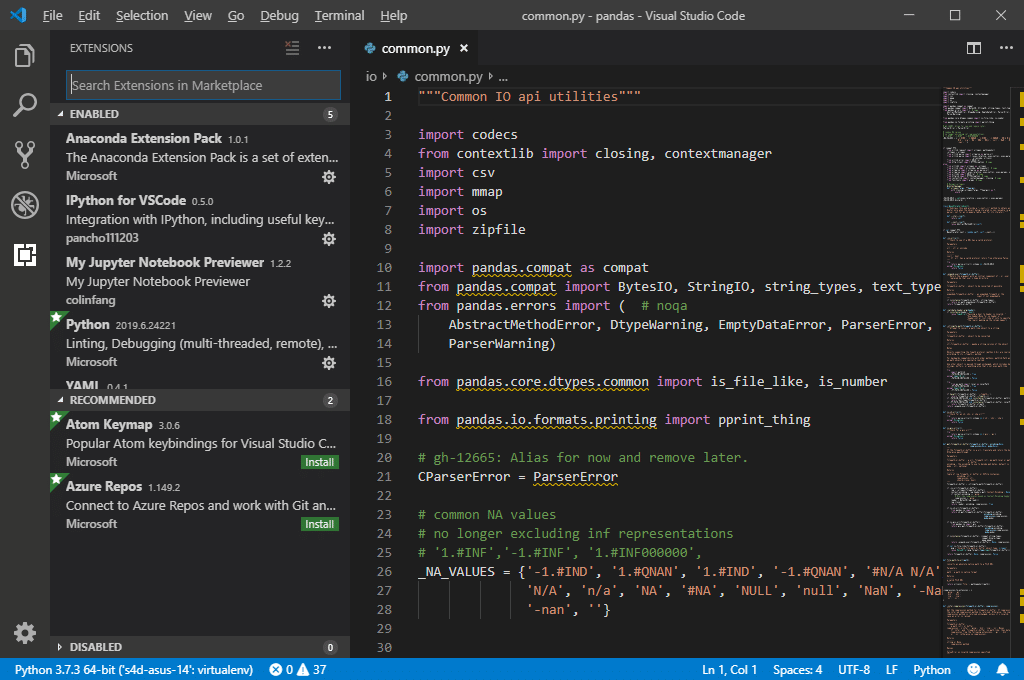

Microsoft a frappé un grand coup avec son IDE VisualStudio Code, avec un outil open source et gratuit, multi-plateforme et multi-langage combiné à sa grande expérience dans les IDE de développement.

Étonnement, l’écosystème open source qui avait beaucoup de réticences à utiliser des outils Microsoft est aujourd’hui conquis par cet outil qui permet de créer des projets complexes et qui évolue extrêmement vite avec le développement des communautés. Grâce à un système d’extensions efficace et simple à mettre en oeuvre, vous adaptez votre IDE à vos besoins, à vos usages et à vos langages. Je vous conseille de l’essayer pour le découvrir.

3. Le deep learning avec PyTorch

Depuis quelques temps, l’écosystème deep learning a eu tendance à se resserrer. En effet, TensorFlow combiné à Keras avec Google caché derrière a réussi à « convertir » la plupart des data scientists. Néanmoins, un environnement deep learning sort du lot depuis quelques mois, il s’agit de PyTorch.

PyTorch est développé par Facebook et est extrêmement efficace pour construire des réseaux de neurones profonds de manière simple et dynamique. Il facilite le débogage (avec des DAG dynamiques) et comporte de nombreux modèles pré-entraînés. Il simplifie l’utilisation du GPU et est extrêmement performant. Je vous conseille de jeter un œil à PyTorch ici.

TensorFlow reste tout de même la référence et TensorFlow 2 qui est actuellement en Beta devrait rattraper le retard pris sur PyTorch. A suivre de près…

4. Le dashboarding avec Voilà

Les outils de data visualisation et de dashboarding sont de plus en plus important dans l’écosystème data. Dans le domaine open source, shiny du côté de R apparaît comme un bon leader. Mais un nouveau venu pourrait changer la donne, il s’agit du projet Voilà de l’écosystème Jupyter. Donc Voilà, c’est un outil qui permet de transformer votre Notebook Jupyter en une application web indépendante ou un dashboard indépendant. Sa force réside dans sa simplicité et dans la richesse de l’écosystème Jupyter.

Votre code disparaît et en utilisant les widgets de Jupyter, vous construisez des dashboard interactifs en créant un serveur web (Voilà utilise Tornado).

Ce projet est extrêmement prometteur, si vous vous y intéressez, n’hésitez pas à aller voir ce blogpost ou le site du projet.

Envie de découvrir nos formations et notre service de conseil pour les outils data science ?

Partager cet article