Data Lake ou Data Warehouse ? Le premier offre souplesse et volume, le second structure et performance. Le bon choix dépend de vos données, de vos usages… et de votre maturité data.

Comment créer un logger structuré et efficace dans un projet Python

Dans un projet python, la gestion des logs est essentielle pour assurer le suivi, le débogage et la maintenabilité du code, surtout dans les projets data. Un bon logger doit être centralisé, réutilisable, structurant et capable d’écrire dans des fichiers. Dans cet article, nous vous montrons comment mettre en place un logger adapté à un projet Python organisé en plusieurs …

Marre du VBA ? Passez à python !

Vous avez forcément entendu parler du box-plot que l’on appelle aussi boîte à moustache pour sa forme originale.

Ce graphique tout simple permet de résumer une variable de manière simple et visuel, d’identifier les valeurs extrêmes et de comprendre la répartition des observations.

Gouvernance des données : principes, approches et rôles clés

La gouvernance des données assure la fiabilité, la sécurité et la qualité de l’information.

Elle s’appuie sur des rôles dédiés (CDO, Data Steward) et des cadres (COBIT, DAMA-DMBOK, DCAM).

Chacun accède aux bonnes données au bon moment.

L’entreprise développe ainsi une culture data favorisant l’innovation.

Utiliser Git et la CI/CD pour les projets Data : guide complet

Git est un système de gestion de versions distribué essentiel pour vos projets data. Il vous permet de suivre chaque modification de scripts, notebooks et fichiers de configuration, tout en facilitant la collaboration via des branches et des pull requests. Couplé à des outils de CI/CD (Intégration et Livraison Continues), vous pouvez automatiser les tests et le déploiement de vos pipelines data, garantissant un code toujours fonctionnel et fiable.

Construire un nuage de points (scatter plot) avec Python

Les nuages de points, ou scatter plots, permettent d’analyser les relations entre deux variables numériques. Cet article explique comment générer des données, utiliser Matplotlib pour tracer ces graphes, et personnaliser les visualisations avec Seaborn. Il aborde également des techniques pour représenter des catégories, ajouter des lignes de régression, et annoter les points.

Lexique de la data science

Ce lexique de la data science fournit des définitions essentielles sur divers termes tels que les algorithmes, l’apprentissage automatique, le big data, et les modèles d’intelligence artificielle. Il s’adresse à ceux qui cherchent à comprendre ces concepts techniques et leur impact sur l’analyse des données et les affaires.

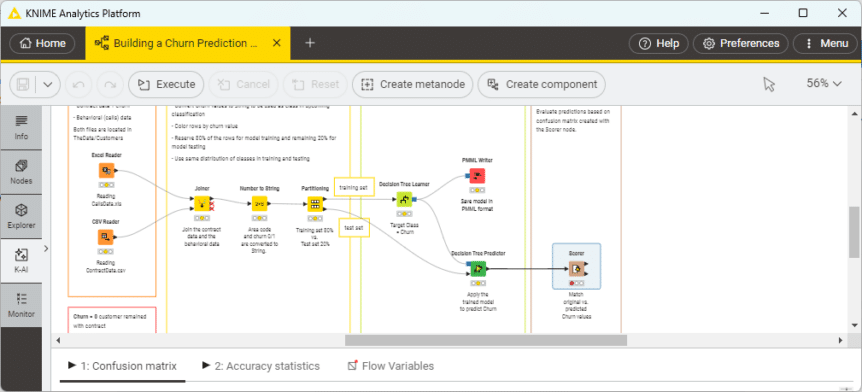

KNIME : une plateforme data science 100 % open source et évolutive

KNIME est une plateforme open source leader en data science, lancée en 2004 et gratuite depuis 2006. Elle permet de préparer, analyser, et automatiser des workflows de données via une interface intuitive basée sur des nœuds. Ses capacités s’étendent à l’IA, le big data, et le NLP, tout en bénéficiant d’une communauté active.

L’évolution du Data Scientist à l’ère de l’IA

Le métier de Data Scientist, décrit comme « sexy » par la Harvard Business Review, reste crucial malgré les avancées en IA et l’automatisation. Ce rôle pluridisciplinaire allie mathématiques, informatique et connaissances métier, évoluant vers des compétences stratégiques, éthiques et créatives. Face à des défis croissants, l’adaptabilité et la formation continue sont essentielles.

Introduction à Polars : Une Alternative Rapide à Pandas

Polars est une bibliothèque de manipulation de données rapide, conçue pour surpasser Pandas en performances. Grâce à son architecture en Rust et à l’utilisation du format Apache Arrow, Polars optimise le traitement des données volumineuses. Elle propose des fonctionnalités comme le multi-threading, une API paresseuse, et une manipulation intuitive via des expressions.